5 марта 2025 года компания Alibaba представила новую большую языковую модель (LLM) с открытым исходным кодом - QwQ-32B. Модель доступна как для коммерческого, так и для исследовательского использования, позволяя компаниям напрямую интегрировать ее в продукты и приложения, в том числе платные. QwQ, сокращение от Qwen-with-Questions - это модель рассуждений с открытым исходным кодом, впервые представленная Alibaba в ноябре 2024 года с целью конкурировать с o1-preview от OpenAI. Оригинальная QwQ улучшила свои возможности логического мышления и планирования, особенно в математических и кодовых задачах, путем анализа и уточнения собственных ответов в процессе рассуждений. Предыдущая версия QwQ имела 32 миллиарда параметров и длину контекста 32 000 токенов, превосходя o1-preview в математических бенчмарках, таких как AIME и MATH, и задачах научного мышления, таких как GPQA.

Несмотря на то, что QwQ-32B имеет всего 32 миллиарда параметров, она демонстрирует производительность, сопоставимую с DeepSeek-R1, моделью с 671 миллиардом параметров. Alibaba заявляет, что QwQ-32B превосходит OpenAI o1-mini и конкурирует с DeepSeek-R1 по производительности в задачах, связанных с математическими рассуждениями, кодированием и общим решением проблем. Этот прорыв подчеркивает потенциал масштабирования обучения с подкреплением (RL) на надежных базовых моделях, предварительно обученных на обширных мировых знаниях.

Ключевые особенности QwQ-32B

QwQ-32B - это причинно-следственная языковая модель, построенная с использованием передовой архитектуры Transformer. Она включает в себя RoPE, SwiGLU, RMSNorm и Attention QKV bias. С 64 слоями и конфигурацией внимания из 40 голов для запросов и 8 для пар ключ-значение, она оптимизирована для задач, требующих глубоких рассуждений. Ее расширенная длина контекста в 32 768 токенов позволяет модели обрабатывать большие входные данные и решать сложные многоступенчатые задачи.

Обучение с подкреплением

Ключевым нововведением в QwQ-32B является интеграция обучения с подкреплением (RL) в процесс обучения. Вместо того чтобы полагаться исключительно на традиционные методы предварительного обучения, модель проходит корректировки на основе RL, которые направлены на повышение производительности в конкретных областях, таких как математика и кодирование. Используя вознаграждения, основанные на результатах, которые проверяются с помощью проверок точности и тестов выполнения кода, модель постоянно совершенствует свои выходные данные. Этот адаптивный подход повышает ее способности к решению задач и помогает ей более эффективно обобщать информацию в различных задачах.

Процесс обучения с подкреплением в QwQ-32B разделен на два этапа: первый фокусируется на математических и кодовых способностях, обучение с верификатором точности и сервером выполнения кода. Второй этап расширяется до общих возможностей, включая вознаграждения от общих моделей вознаграждения и верификаторов на основе правил.

Агентные возможности

QwQ-32B также обладает агентскими возможностями, динамически корректируя свой процесс рассуждений на основе обратной связи с окружающей средой. Команда Qwen успешно интегрировала агентные возможности в модель рассуждений, позволяя ей критически мыслить, использовать инструменты и адаптировать свои рассуждения на основе обратной связи с окружающей средой. «Масштабирование RL может повысить производительность модели за пределы традиционных методов предварительного обучения и последующего обучения», - заявила команда. «Недавние исследования показали, что RL может значительно улучшить возможности рассуждений моделей».

Команда Qwen рекомендует использовать определенные настройки рассуждений для оптимальной производительности и поддерживает развертывание с помощью vLLM

Сравнение QwQ-32B с другими моделями

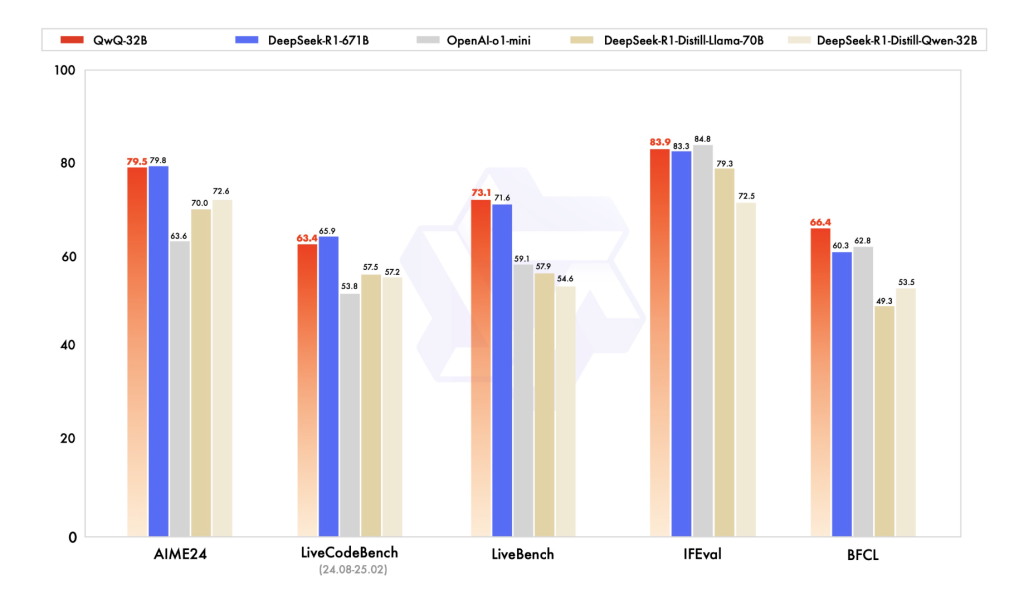

QwQ-32B продемонстрировала конкурентоспособные результаты в сравнении с другими ведущими моделями, такими как DeepSeek-R1, o1-mini и DeepSeek-R1-Distilled-Qwen-32B, несмотря на то, что имеет меньше параметров, чем некоторые конкуренты. Например, DeepSeek-R1 имеет 671 миллиард параметров (37 миллиардов активированных), в то время как QwQ-32B обеспечивает сопоставимую производительность при значительно меньших требованиях к VRAM, обычно требуя 24 ГБ на GPU, по сравнению с DeepSeek R1, которому требуется более 1500 ГБ.

Модель была протестирована на различных бенчмарках, включая AIME24, LiveCodeBench, LiveBench, IFEval и BFCL, разработанных для оценки ее математических рассуждений, навыков кодирования и общих способностей к решению задач.

AIME: American Invitation Mathematics Evaluation, который проверяет решение математических задач с помощью арифметики, алгебры, подсчета, геометрии, теории чисел, вероятности и других математических тем средней школы.

MATH-500: 500 тестовых случаев бенчмарка MATH, всеобъемлющего набора данных, проверяющего решение математических задач.

GPQA: Graduate-Level Google-Proof Q&A Benchmark, сложный бенчмарк для оценки способностей к решению научных задач с помощью вопросов уровня начальной школы.

LiveCodeBench: сложный бенчмарк для оценки способностей к генерации кода и решению задач в реальных сценариях программирования.